目前大模型应用如火如荼,各大LLM如Deepseek也都提供了在线的助手服务,结合mcp-server还可以进一步拓展到本地的工具能力。

但对于一些和本地业务和数据强相关的资料,在线的大模型训练数据集一般并不能涵盖,特别还有一些敏感或对安全要求很高的数据,使用在线大模型并不现实。所以我们个人应用和实际工作中,本地部署大模型并加入本地知识库也是一个刚性需求。

本文就记录下在WSL中通过Ollama和CherryStudio搭建本地大模型,并将本地模型集成到VsCode的AI助手的过程分享。

Ollama简介

Ollama 是一个基于Go 语言开发的简单易用的本地大语言模型运行框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。Ollama 是 Omni-Layer Learning Language Acquisition Model(全方位学习语言接受模型) 的简写。

Deepseek本地模型及运行配置

Deepseek目前根据本地部署包含的参数集大小,又包含 1.5B 到 671B 等多个版本,参数集越大则AI越智能,但相应地对硬件要求则越高。

一般对应不同deepseek模型版本,推荐的硬件配置如下:

| 模型型号 | CPU | 内存 | 硬盘 | 显存 | 适用场景 |

|---|---|---|---|---|---|

| DeepSeek-R1-1.5B | 4 核 | 8 GB+ | 3 GB+ | 非必需(若需 CPU 加速可选 GTX 1650) | 个人使用,如笔记本电脑、台式电脑等 |

| DeepSeek-R1-7B | 8 核 | 16 GB+ | 8 GB+ | 8 GB+显存(如 RTX 3070/4060) | 中小型企业本地开发 |

| DeepSeek-R1-8B | 8 核 | 16 GB+ | 8 GB+ | 8 GB+显存 | 中小型企业本地开发(提升精度的轻量级任务) |

| DeepSeek-R1-14B | 12 核 | 32 GB+ | 15 GB+ | 16 GB+显存(如RTX 4090 或 A5000) | 中小型企业本地开发(中量级任务) |

| DeepSeek-R1-32B | 16 核 | 64 GB+ | 30 GB+ | 24 GB+显存(如 A100 40 GB 或 RTX 3090) | 专业领域任务,如医疗、科研、法律 |

| DeepSeek-R1-70B | 32 核 | 128 GB+ | 70 GB+ | 多卡并行(如 2x A100 80GB 或 4x RTX 4090) | 大型企业或科研机构,专业领域任务处理 |

| DeepSeek-R1-671B(满血版) | 64 核 | 512 GB+ | 300 GB+ | 多卡并行(如 8x A100/H100) | 国家级科研任务处理 |

| 对我们个人用户来说,根据自己的电脑配置情况,通常选择1.5B到14B。 当然如果不是高频使用本地模型,个人建议可以将配置和推荐模型降一档匹配。 |

利用Ollama在WSL中部署本地Deepseek

因为笔者当前主要是希望将一些本地数据接入Deepseek,也没有高频使用本地LLM的需求。所有这里我选择部署 DeepSeek-R1-14B, 另外为了避免每次启动电脑都因为LLM运行占用大量资源,所以这里我希望在Windows电脑的WSL下运行LLM

WSL配置

如果当前系统还没有启用WSL,可以先启用(过程不再详述, Win11中运行WSL install [对应Linux发行版] 即可安装)

通过命令行查看WSL状态:

| |

WSL默认的网络模式是NAT,这里可以通过WSL Setting程序,修改下当前配置,改为Mirrored镜像模式,共用宿主机网络。

安装Ollama

进入Ollama官网(https://ollama.com/)下载界面, 因为我们是在WSL中部署,所以选择Linux安装。

执行如下命令,等待下载并自动安装完成。

| |

部署deepseek

完成ollama安装后,就可以根据Ollama提供的大模型清单,选择对应大模型进行安装。目前支持的大模型清单,可以从官网如下地址查询:https://ollama.com/library

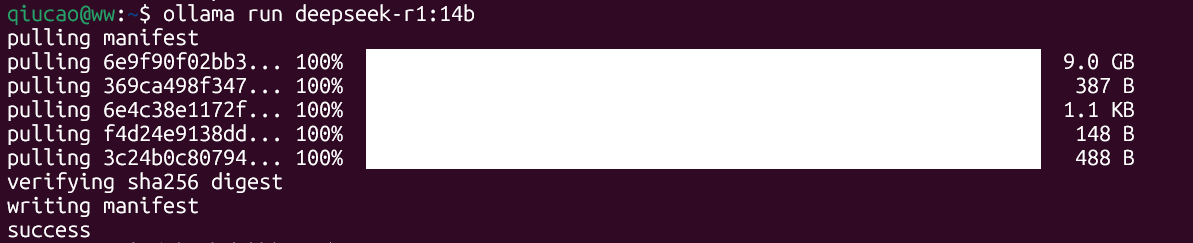

执行如下命令下载并运行deepseek

| |

安装成功后可以提问测试一下deepseek是否已正常提供服务

添加知识库分析模型

至此,Deepseek其实已在本地部署。但如果要通过Deepseek使用本地数据和文档,我们还需要部署一个语义向量模型(Embedding Model),用来将本地数据转化为大模型可分析的知识库数据。这里我们选择 bge-m3 模型,这是一个通用向量模型,可以支持多语言、长文本和多种检索方式。

执行:

| |

用Cherry Studio管理知识库并提供本地交互界面

安装完Deepseek后,虽然我们可以在命令界面下和deepseek进行交互,但还是不够友好,包括对本地知识库的管理也不够方便。所以这里我们还可以安装一个开源的本地AI助手和知识库客户端Cherry Studio。从官网(https://cherry-ai.com)下载windows版本安装即可。

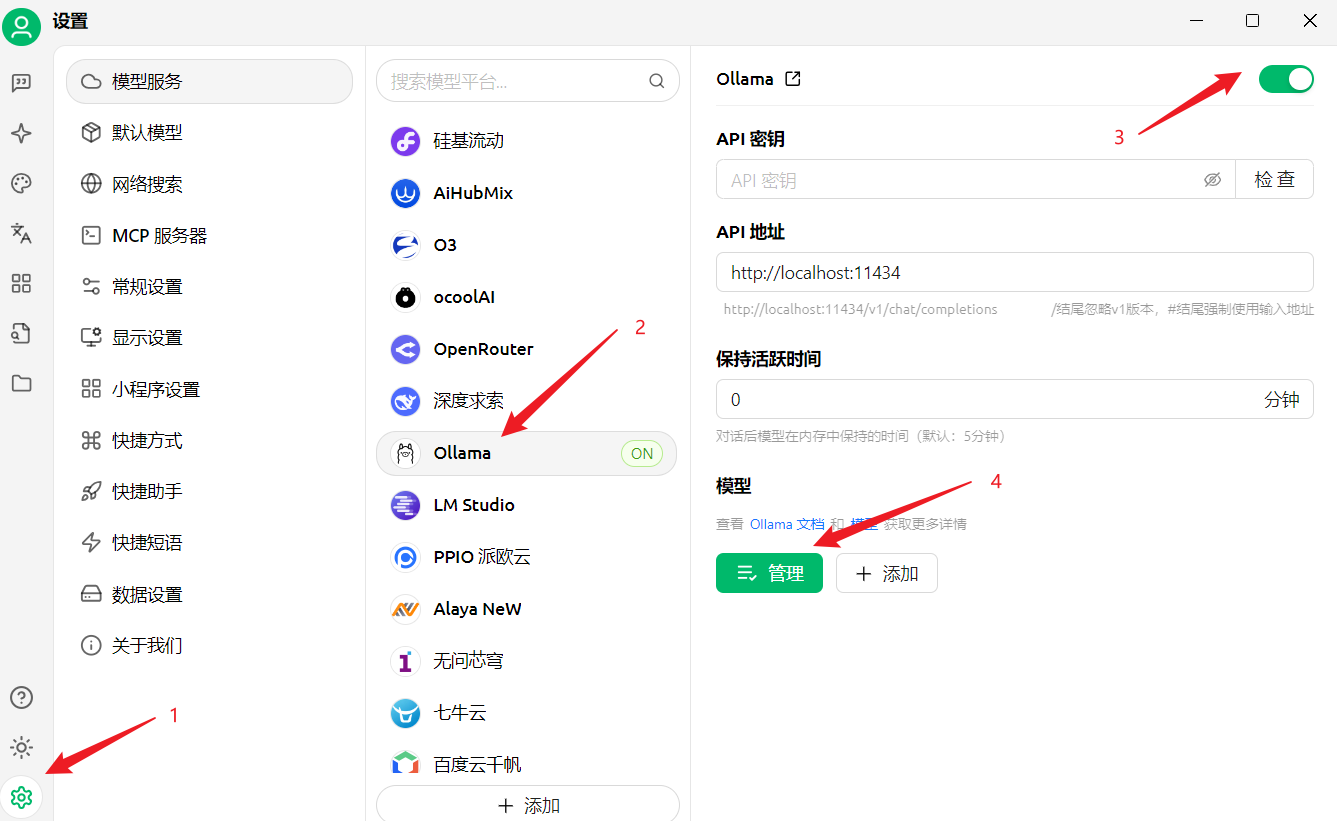

打开Cherry Studio,按如下步骤添加我们刚刚通过ollama部署的Deepseek

会看到已经安装好的模型,添加进来

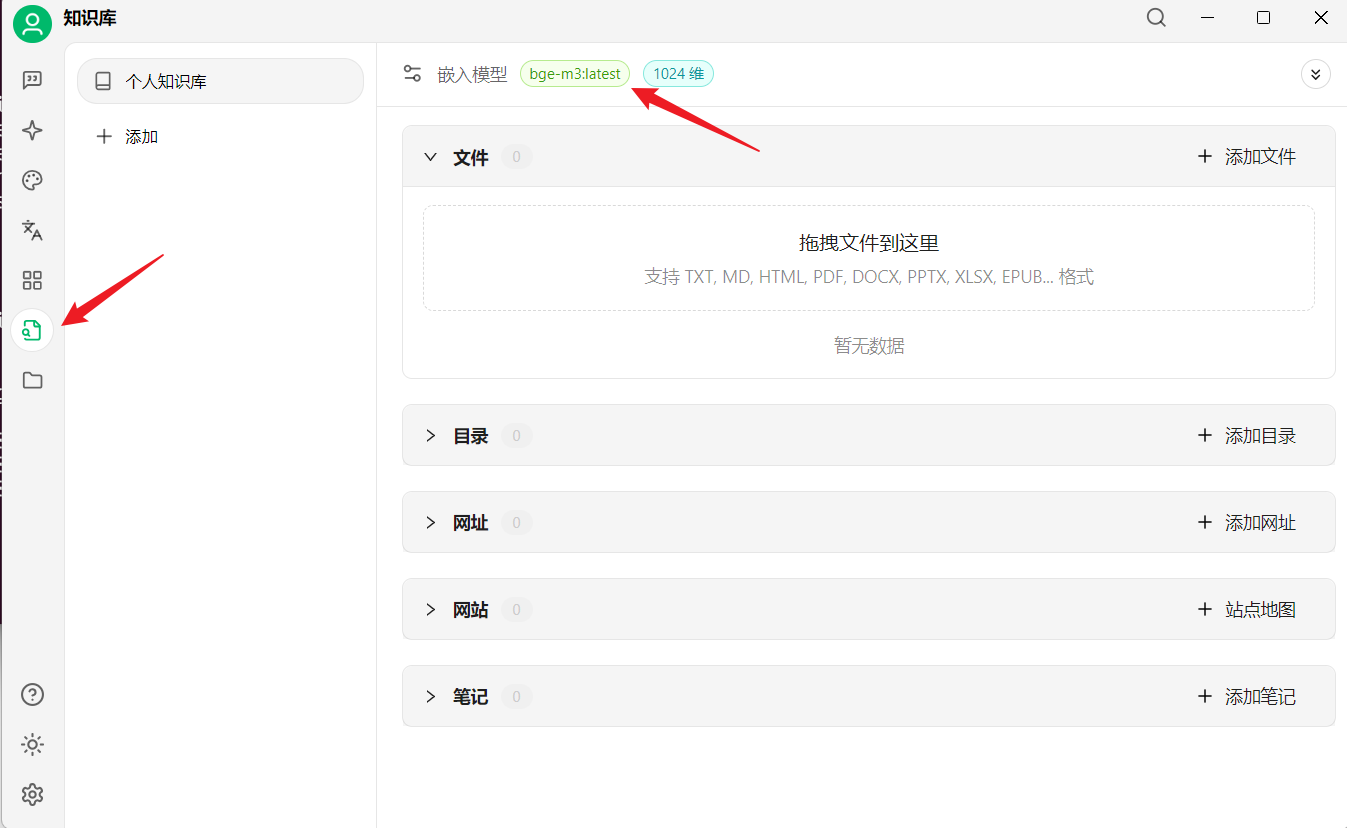

然后就可以利用Cherry Studio的知识库管理,将我们需要加入的本地文档纳入大模型的数据集中。这里包括直接添加文件、直接指定目录、从网站采集等多种方式,非常方便。

然后就可以利用Cherry Studio的知识库管理,将我们需要加入的本地文档纳入大模型的数据集中。这里包括直接添加文件、直接指定目录、从网站采集等多种方式,非常方便。

集成本地Deepseek到vscode

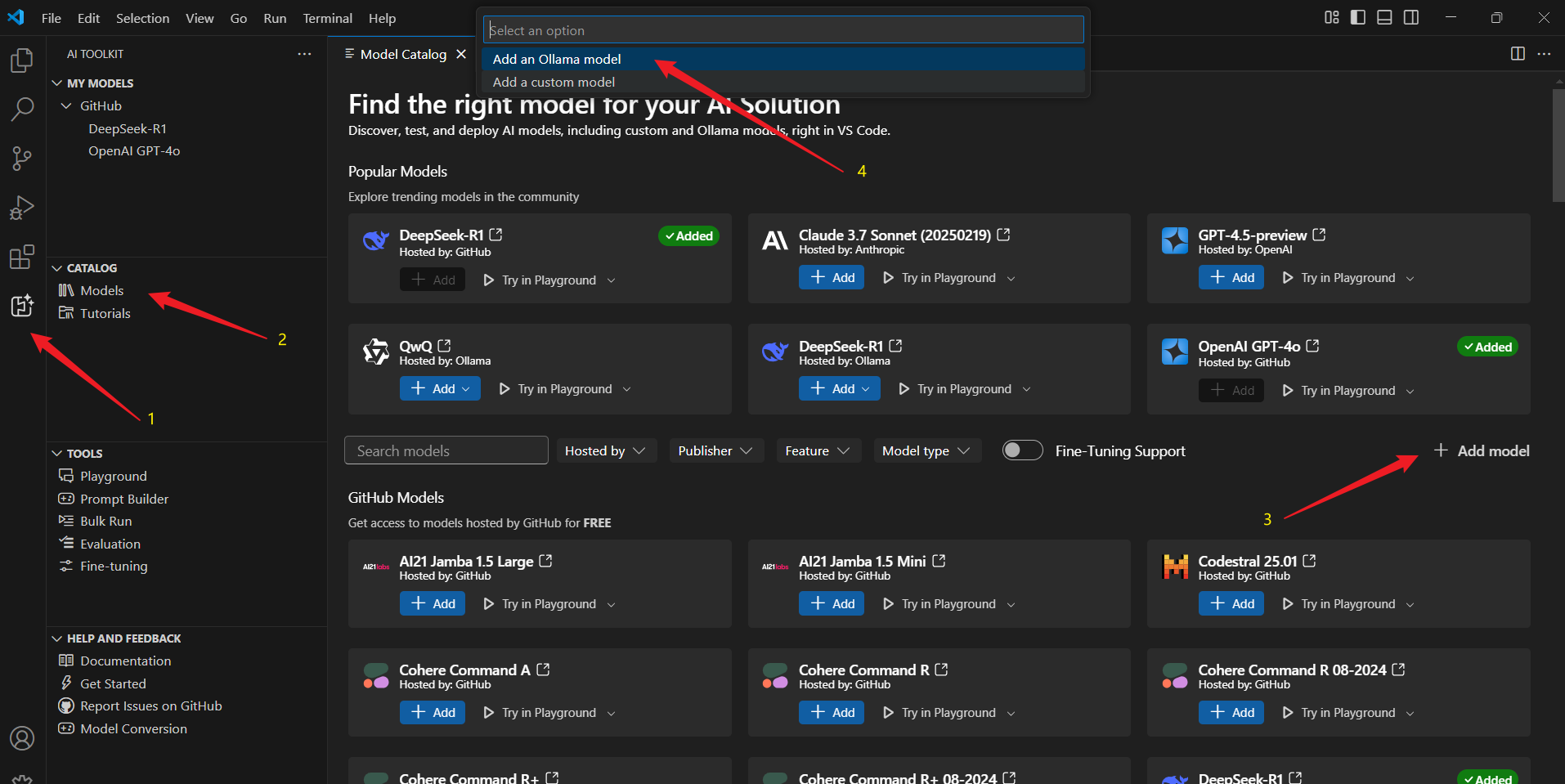

而有了本地的LLM后,如果我们希望在vscode中使用,可以利用vscode 的 AI Toolkit 插件,按如下方式添加本地LLM

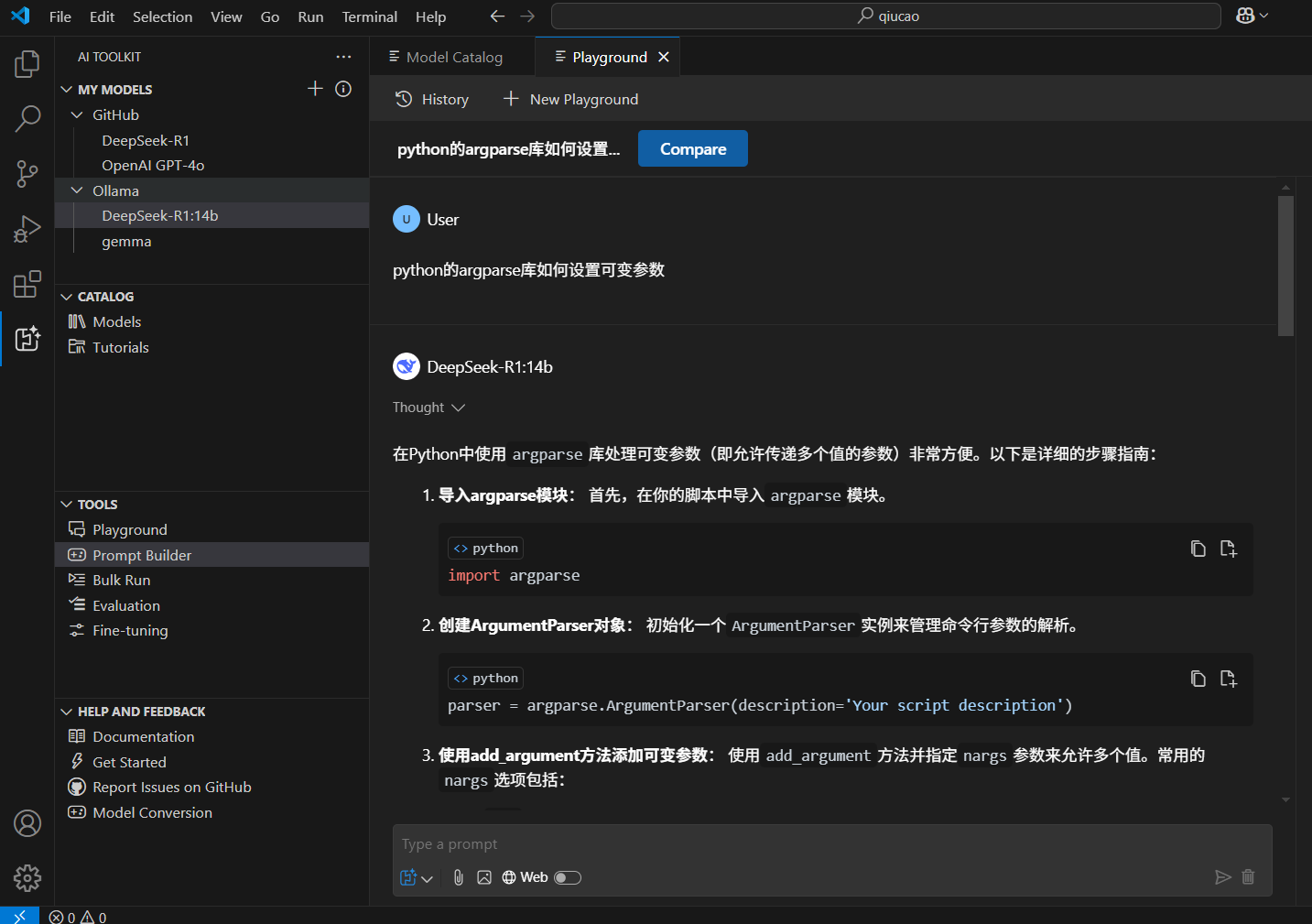

vscode中测试下本地库的能力

以上就是我们部署本地Deepseek的实践分享